经典卷积神经网络结构——LeNet-5、AlexNet、VGG-16

本文共 2130 字,大约阅读时间需要 7 分钟。

作者: 地址:

1. LeNet-5(modern)

1.1 LeNet-5 结构:

- 输入层

图片大小为 32×32×1,其中 1 表示为黑白图像,只有一个 channel。

- 卷积层

filter 大小 5×5,filter 深度(个数)为 6,padding 为 0, 卷积步长 s=1s=1,输出矩阵大小为 28×28×6,其中 6 表示 filter 的个数。

- 池化层

average pooling,filter 大小 2×2(即 f=2f=2),步长 s=2s=2,no padding,输出矩阵大小为 14×14×6。

- 卷积层

filter 大小 5×5,filter 个数为 16,padding 为 0, 卷积步长 s=1s=1,输出矩阵大小为 10×10×16,其中 16 表示 filter 的个数。

- 池化层

average pooling,filter 大小 2×2(即 f=2f=2),步长 s=2s=2,no padding,输出矩阵大小为 5×5×16。注意,在该层结束,需要将 5×5×16 的矩阵flatten 成一个 400 维的向量。

- 全连接层(Fully Connected layer,FC)

neuron 数量为 120。

- 全连接层(Fully Connected layer,FC)

neuron 数量为 84。

- 全连接层,输出层

现在版本的 LeNet-5 输出层一般会采用 softmax 激活函数,在 LeNet-5 提出的论文中使用的激活函数不是 softmax,但其现在不常用。该层神经元数量为 10,代表 0~9 十个数字类别。(图 1 其实少画了一个表示全连接层的方框,而直接用 y^y^ 表示输出层。)

1.2 LeNet-5 一些性质:

- 如果输入层不算神经网络的层数,那么 LeNet-5 是一个 7 层的网络。(有些地方也可能把 卷积和池化 当作一个 layer)

- LeNet-5 大约有 60,000 个参数。

- 随着网络越来越深,图像的高度和宽度在缩小,与此同时,图像的 channel 数量一直在增加。

- 现在常用的 LeNet-5 结构和 中提出的结构在某些地方有区别,比如激活函数的使用,现在一般使用 ReLU 作为激活函数,输出层一般选择 softmax。

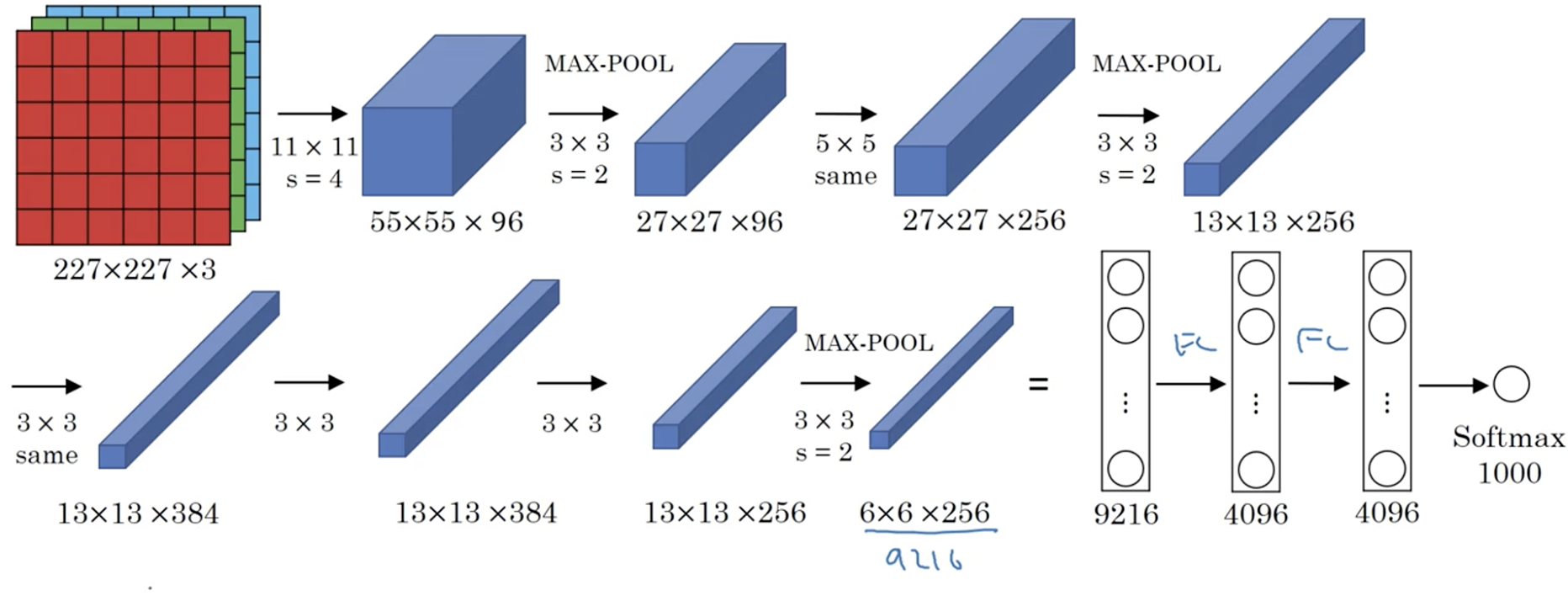

2. AlexNet

2.1 AlexNet 结构:

- 输入层:图像大小为 227×227×3,其中 3 表示输入图像的 channel 数(R,G,B)为 3。

- 卷积层:filter 大小 11×11,filter 个数 96,卷积步长 s=4s=4。(filter 大小只列出了宽和高,filter矩阵的 channel 数和输入图片的 channel 数一样,在这里没有列出)

- 池化层:max pooling,filter 大小 3×3,步长 s=2s=2。

- 卷积层:filter 大小 5×5,filter 个数 256,步长 s=1s=1,padding 使用 same convolution,即使得卷积层输出图像和输入图像在宽和高上保持不变。

- 池化层:max pooling,filter 大小 3×3,步长 s=2s=2。

- 卷积层:filter 大小 3×3,filter 个数 384,步长 s=1s=1,padding 使用 same convolution。

- 卷积层:filter 大小 3×3,filter 个数 384,步长 s=1s=1,padding 使用 same convolution。

- 卷积层:filter 大小 3×3,filter 个数 256,步长 s=1s=1,padding 使用 same convolution。

- 池化层:max pooling,filter 大小 3×3,步长 s=2s=2;池化操作结束后,将大小为 6×6×256 的输出矩阵 flatten 成一个 9216 维的向量。

- 全连接层:neuron 数量为 4096。

- 全连接层:neuron 数量为 4096。

- 全连接层,输出层:softmax 激活函数,neuron 数量为 1000,代表 1000 个类别。

2.2 AlexNet 一些性质:

- 大约 60million 个参数;

- 使用 ReLU 作为激活函数。

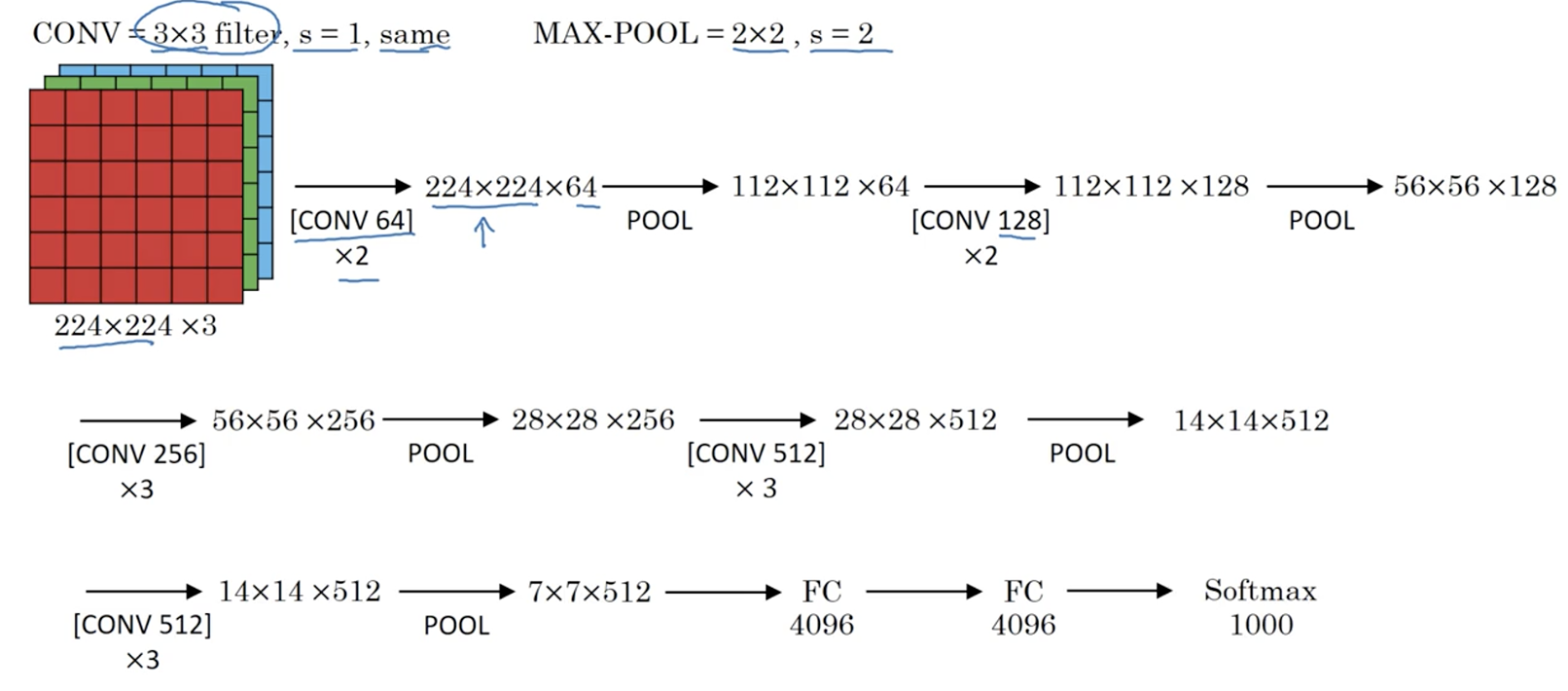

3. VGG-16

3.1 VGG-16 结构:

- 输入层

- 卷积层

- 卷积层

- 池化层

- 卷积层

- 卷积层

- 池化层

- 卷积层

- 卷积层

- 卷积层

- 池化层

- 卷积层

- 卷积层

- 卷积层

- 池化层

- 卷积层

- 卷积层

- 卷积层

- 池化层

- 全连接层

- 全连接层

- 全连接层,输出层

3.2 VGG-16 一些性质:

- VGG-16 中的 16 表示整个网络中有 trainable 参数的层数为 16 层。(trainable 参数指的是可以通过 back-propagation 更新的参数)

- VGG-16 大约有 138million 个参数。

- VGG-16 中所有卷积层 filter 宽和高都是 3,步长为 1,padding 都使用 same convolution;所有池化层的 filter 宽和高都是 2,步长都是 2。

转载地址:http://xhkqf.baihongyu.com/

你可能感兴趣的文章

(PAT 1019) General Palindromic Number (进制转换)

查看>>

(PAT 1080) Graduate Admission (排序)

查看>>

Play on Words UVA - 10129 (欧拉路径)

查看>>

mininet+floodlight搭建sdn环境并创建简答topo

查看>>

【linux】nohup和&的作用

查看>>

Set、WeakSet、Map以及WeakMap结构基本知识点

查看>>

【NLP学习笔记】(一)Gensim基本使用方法

查看>>

【NLP学习笔记】(二)gensim使用之Topics and Transformations

查看>>

【深度学习】LSTM的架构及公式

查看>>

【python】re模块常用方法

查看>>

剑指offer 19.二叉树的镜像

查看>>

剑指offer 20.顺时针打印矩阵

查看>>

剑指offer 23.从上往下打印二叉树

查看>>

Leetcode C++《热题 Hot 100-18》538.把二叉搜索树转换为累加树

查看>>

Leetcode C++《热题 Hot 100-21》581.最短无序连续子数组

查看>>

Leetcode C++《热题 Hot 100-22》2.两数相加

查看>>

Leetcode C++《热题 Hot 100-23》3.无重复字符的最长子串

查看>>

Leetcode C++《热题 Hot 100-24》5.最长回文子串

查看>>

Leetcode C++《热题 Hot 100-28》19.删除链表的倒数第N个节点

查看>>

Leetcode C++《热题 Hot 100-29》22.括号生成

查看>>